Pues resulta que por motivos profesionales llevo unos días pensando y debatiendo mucho acerca de esta cuestión: cómo gestionamos el hecho (real y actual) de que el alumnado utiliza herramientas de Inteligencia Artificial en el contexto académico, y lo hace de manera masiva. ¡Es el tema de moda!

El caso es que veo a mis alumnos y alumnas, y usan ChatGPT para todo. Le preguntan cosas que les costaría tres segundos responder por otra vía (más directa y fiable). La usan para conversar y pasar el rato. Confían en las respuestas ciegamente y a veces lo que más me flipa es que confían aunque contradiga la realidad manifiesta. ¿A quién vas a creer, a tus propios ojos o a ChatGPT? Pues eso. Esto último no es sorprendente, y lo demuestran investigaciones que indican que hemos construido una máquina particularmente persuasiva, para lo bueno (por ej., sacarte del pozo de las teorías conspirativas; Costello et al., 2024, 2025) y para lo malo (por ej., si la respuesta de la IA se equivoca puede empeorar tu rendimiento en una tarea muy sencilla de resolver; Vicente & Matute, 2023).

Dado que se utiliza tantísimo, hay una presión muy grande para integrar esta herramienta en el trabajo del aula, sea de una manera u otra, y en todos los niveles educativos (aunque yo me centro en el mío, que es la universidad). Y es donde me he encontrado con posiciones y argumentos que considero quizá extremistas, sea por un lado (alarmismo injustificado, vamos a morir todos) o por el otro (“la IA es el futuro, reemplacemos a los profesores”; Merlan, 2025).

Mi posición es que, por un lado, tenemos ante nosotros una herramienta con potencial y que ha transformado el mundo para bien o para mal (quizá el debate es si hay más de lo primero o de lo segundo), así que necesariamente tenemos que educar en su uso para que nuestro alumnado esté preparado para el reto que supone. Pero por otro lado, lanzarse a los brazos de las grandes corporaciones para dejar que nos manipulen como deseen tampoco me parece razonable. Digamos que estoy en un punto intermedio. Supongo. Mi postura va evolucionando conforme leo cosas y observo el mundo.

Así que este post lo voy a usar como tablón para exponer mi opinión actual (siempre en proceso de cambio) en torno a este tema y para argumentarla. No pretendo convencer a nadie, no me toméis muy en serio. Pero me parece que con todo lo que he leído y discutido del asunto, es interesante aclarar mis ideas y ponerlas en orden.

Por cierto, aunque en este texto use el término IA o Inteligencia Artificial, que como científico cognitivo que soy tampoco me entusiasma mucho, me voy a centrar básicamente en modelos de lenguaje (Large Langauage Models, LLM) como ChatGPT, porque son los más populares actualmente. Además, sé que existen aplicaciones específicas de distintas tecnologías y arquitecturas de IA para resolver problemas diversos que son muy prometedoras. Pero rindámonos a la evidencia: mis alumnos no suelen programarse una red neuronal recurrente para resolver sus dudas, sino que se conectan al chatbot de ChatGPT y le preguntan qué tiempo va a hacer mañana.

Los tres requisitos para el uso responsable de la IA

Mi argumento parte de una obviedad: las aplicaciones de IA como ChatGPT son una herramienta. Como tal, se pueden utilizar de manera responsable o irresponsable. ¿Qué es lo que considero un uso responsable en el contexto educativo?

Para responder a la pregunta, la piedra angular de mi argumento es que, al usar este tipo de herramienta, estamos delegando una actividad en el software. O sea, a menudo no es como usar un cuchillo para cortar el pan, sino más bien como pedir a alguien que venga con su cuchillo y lo corte por ti. Esto puede ser muy conveniente y útil en determinadas situaciones.

Pero claro, hay que ser consciente de que tú no estás haciendo la actividad, sino que la estás delegando, es decir, te la está haciendo “alguien”. Para lo bueno y para lo malo. Esto creo que tiene implicaciones en el contexto educativo que luego comentaré.

Partiendo de esta idea, propongo que podemos reducir las situaciones de uso responsable de las herramientas de IA en el contexto educativo a las que cumplen con tres requisitos:

- La actividad que delegas en la IA no está siendo objeto de evaluación en este momento.

- No necesitas o no quieres en este momento ejercitar la habilidad para realizar la actividad que has decidido delegar.

- Tenemos la capacidad y posibilidad de verificar que el resultado es correcto.

A continuación explico los tres requisitos uno por uno.

Requisito 1. La evaluación: no siempre que usas una IA estás haciendo trampa

Este es el tema que más controversia genera (Bin-Nashwan et al., 2023; Walsh, 2025), por sus ramificaciones éticas y legales, aunque quizá para mí es el menos importante de los tres. Yo, como otros, lo veo como una cuestión de honestidad académica, pero también pienso que afecta al diseño de la propia evaluación y toca de lleno en el asunto de la confianza entre las partes. A ver.

Cuando diseñamos una evaluación, el supuesto en el que se basa todo es que la persona cuya habilidad es evaluada la está usando realmente. Por ejemplo, si estoy haciendo una encuesta en la que pregunto a la gente cuánto tiempo aguanta bajo el agua, asumo que nadie me va a trolear respondiendo que puede aguantar horas, pero paseando en un submarino.

Lo que pasa es que si la evaluación está mal diseñada, entonces a veces es posible resolverla satisfactoriamente sin poner en juego la habilidad evaluada. O sea, que si no prevemos de alguna manera el uso de herramientas IA en la evaluación, y esas herramientas se usan frecuentemente, corremos el riesgo de estar evaluando otra cosa.

De todas maneras, esto no impide que podamos usar inteligencia artificial en la evaluación de manera responsable: lo importante es que la habilidad que se está evaluando en este momento no esté siendo delegada en la herramienta (o en otra persona, que vendría a ser lo mismo).

Por poner un símil, si quiero evaluar la capacidad de sintetizar textos en la forma de un trabajo académico, podemos plantearnos usar una IA para pulir la redacción, o para generar algún tipo de esquema, o para traducir esos textos si están en otro idioma… Todo eso son actividades que (tal como lo veo) no están siendo evaluadas en el trabajo como lo hemos diseñado. Se supone que no quiero evaluar si redactas bien, o si cometes faltas de ortografía… La habilidad que quiero evaluar sigue estando ahí y por eso usar la IA de esa manera no merma sustancialmente mi evaluación.

Ahora bien, si lo que hace el/la estudiante es pedir a ChatGPT “escríbeme un ensayo de veinte páginas sobre el tema tal”, y a continuación copiapegarlo y ponerle su nombre en la portada… Todos entendemos que ahí la actividad de evaluación está mal enfocada, ¿verdad? Porque se está resolviendo la tarea sin usar la habilidad.

Por lo tanto, la moraleja es que tenemos que plantear situaciones de evaluación que pongan algún tipo de límite a la delegación de las habilidades que queremos medir.

Requisito 2. Actividad no ejercitada, competencia no adquirida

Este es el elemento central, el que más me interesa. Ser competente en un dominio concreto implica una combinación de conocimientos, habilidades y aptitudes (Illeris, 2004; McClelland, 1973). A menudo, sobre todo en el caso de las habilidades, para llegar a un grado de maestría aceptable necesitamos práctica. Difícilmente vas a ser un buen ciclista si nunca te subes a una bicicleta.

Así, un elemento fundamental de toda experiencia de aprendizaje es el ejercicio de la habilidad que nos interese mejorar. Incluso la adquisición de conocimientos, por cierto, también requiere a menudo un esfuerzo, y no siempre es posible aprender un concepto, o comprenderlo, a base de exponerse pasivamente al mismo.

Por este motivo, los docentes solemos incorporar a nuestras clases actividades, ejercicios, preguntas… Son un elemento fundamental porque además de proporcionar información para la (auto)evaluación, constituyen oportunidades de práctica, y por lo tanto de ejercitar la habilidad e ir fortaleciéndola. La primera vez que lees un artículo científico, tardas mucho y te enteras de poco. Cuando llevas leídos veinte o treinta, ya le has pillado el truco. Es como ir al gimnasio para entrenar un músculo.

Ahora viene lo interesante: ¿qué pasa cuando delegamos una actividad en la IA? Pues básicamente lo mismo que cuando la delegamos en otra persona. No es muy diferente preguntar a ChatGPT “hazme un resumen de este texto” que pedirle a un compañero que lo haga, o copiarlo de internet. El resultado es un documento, un trabajo escrito, pero lo de menos es ese documento o su calidad. Se trataba de practicar, de adquirir la habilidad o perfeccionarla. Y al haberla delegado, no has hecho ese ejercicio que necesitabas.

De nuevo, nos podemos plantear si el ejercicio estaba bien planteado. A fin de cuentas, si se puede resolver la tarea sin usar la habilidad, cabe pensar que el diseño del ejercicio es erróneo. Imagina que quiero que te ejercites subiendo escaleras, pero lo que te digo es que nos vemos en el décimo piso y no te aviso de que no puedes coger el ascensor. Mal diseño.

Por otro lado, no siempre es posible culpar al diseño de la actividad. El usuario también tiene que ser responsable en el uso de la herramienta. Imagino que nadie me impide llevarme una carretilla elevadora al gimnasio, cargarla de pesas y levantarlas unas cuantas veces sin hacer ningún esfuerzo. También podría pedir a un compañero que fuese al gimnasio por mí, y dudo que el reglamento lo prohibiese. Pero si lo hiciera, sería una tontería que desvirtúa la actividad misma, ya que el objetivo de la actividad es ejercitarse, no levantar las pesas del suelo. Es algo que el propio usuario debería ser capaz de evitar instantáneamente.

¿Es este un pensamiento ingenuo por mi parte? No lo sé. Pero hay estudiantes que ya se han olido la tostada y por eso evitan abusar de esta tecnología (si nos creemos su relato).

Por supuesto, de nuevo conviene plantear algunas distinciones útiles para no mezclar churras con merinas. La IA te permite automatizar y delegar tareas que, a lo mejor, no necesitas ejercitar en este momento. ¡Y eso es bueno! Tareas simples y repetitivas que no suponen un enriquecimiento significativo de tus habilidades, o tareas que ya sabes hacer, o simplemente tareas de relevancia secundaria en el trabajo a las que no quieres prestar atención ahora miso. Por ejemplo: reorganizar textos, resumirlos, revisar la ortografía o la sintaxis… podrían entrar dentro de esta categoría en ocasiones, dependiendo del contexto. En principio, dado que no necesitamos ejercitar la habilidad en este preciso momento, no pasa nada por delegar en la herramienta, y así tendrías más tiempo para centrarte en lo importante.

Ahora bien, insisto: no siempre las tareas que delegamos en la IA son las que no necesitamos practicar. A veces simplemente delegamos porque no tenemos tiempo, o ganas. Como el que se salta el gimnasio. Y ahí ocurre lo que decía antes: Habilidad no ejercitada, habilidad que a lo mejor no vas a dominar. Si nunca has intentado cocinar una fideuá ni nada que se le parezca, es difícil que alcances la excelencia cocinando ese plato.

Y oye, no pasa nada si no saber cocinar una fideuá. Por supuesto (si quieres), puedes delegar esa actividad en una multinacional a cambio de tus datos, o de tu dinero. Pero hay habilidades que sí son más cruciales. Leer. Escribir. Argumentar. A eso voy.

Y como mínimo, tienes que ser consciente de las consecuencias: si no te ejercitas, no te desarrollas. Lo cual puede ser aceptable a veces, pero a veces no. Por eso hay quien hace comparaciones que me parecen lamentables: “Usar ChatGPT hoy es como usar la calculadora: simplemente una herramienta. En el futuro la usaremos para todo”. Bueno, sí y no. Puedes usarla de esa manera, pero asumiendo las consecuencias de esa delegación de funciones. Desde hace mucho existe software capaz de recitar un texto en voz alta, pero imagino que nadie estaría dispuesto a defender que la lectura está obsoleta. Que dejemos de enseñar a los niños y niñas a leer. Que total, ya hay una tecnología en manos de grandes corporaciones super poderosas que va a librarnos de esa carga, tener que leer por nosotros mismos. Un futuro nada distópico nos espera, nenes.

Requisito 3: Verificación. La máquina de dar gato por liebre.

Y aquí es donde el símil de la calculadora hace agua, porque esta calculadora no da siempre la respuesta correcta, no es fiable. Todo el mundo que sabe algo del tema coincide en la necesidad de verificar cuidadosamente las respuestas de ChatGPT.

Sin embargo, entre los usuarios de la herramienta, que a menudo no conocemos sus entresijos, percibo una sobrestimación enorme de sus capacidades. No es raro encontrarme con alumnado (¡o también colegas míos!) que le preguntan dudas como si fueran un oráculo o un ser omnisciente. Y no les culpo, es algo generalizado: tenemos artículos periodísticos a tutiplén con premisa bastante absurdas como “hemos preguntado a ChatGPT por el tiempo que va a hacer este verano y esto es lo que nos ha contado”, o “el número premiado en la lotería según ChatGPT”… Un sinsentido y un ridículo, en fin. La herramienta no se ha diseñado para predecir el futuro, ni la meteorología, sino para generar frases que den el pego.

Detengámonos un poco ahí. ¿Para qué fue diseñada chatGPT?

Existen diversas arquitecturas y distintos sistemas de aprendizaje artificial, pero ChatGPT (junto con otros como Deepseek) pertenece a una familia de modelos generativos llamados LLM (Large Language Models), que son básicamente sistemas de predicción de palabras. Piensa en el texto predictivo del teclado de tu móvil: ¿te has preguntado cómo lo hace para “adivinar” la palabra que quieres usar en cada momento? Lo que hace es examinar una base de datos de palabras y después basa su predicción en un modelo estadístico que ha aprendido a partir de su uso.

Bueno, pues esta familia (los LLM) hacen básicamente esto mismo, pero con la salvedad de que se los ha alimentado con tooooodos los textos que existen en internet (por cierto, pasándose las legislaciones y el copyright por los microchips, ojo).

Esto dota a los LLM de una capacidad asombrosa de producir textos en lenguaje natural aparentemente indistinguible de los de un humano. Es un hito increíble de la tecnología, es cierto, pero se trata de imitar una actividad humana (la expresión lingüística) de manera que “da el pego”. Un acto de ilusionismo muy convincente, si quieres.

Y lo llamo ilusionismo porque esta capacidad lingüística, si bien es asombrosa, no implica que la IA “conozca” nada, ni “entienda” lo que dice. Así, si le propones un problema de lógica que podría resolver un niño (el famoso juego del barquero, el lobo, la oveja y la lechuga), podrá hacerlo bien, pero si cambias uno de los elementos para convertirlo en esencialmente el mismo problema, pero con otras palabras (si cambias el lobo por, yo qué sé, un T. Rex), entonces “peta”.

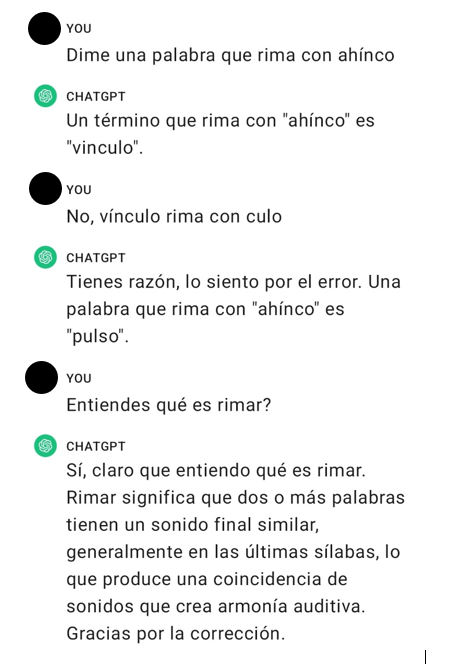

Otro ejemplo: ChatGPT 3.5 puede hacer poemas y rimar palabras, pero fácilmente entra en contradicciones.

Así, no conviene fiarse de estos modelos para resolver tareas lógicas o matemáticas. No están diseñados para ello, solo para generar frases.

Pero no es que la IA “sea tonta”. Es otra cosa, y hay errores más preocupantes. Hay dos conceptos importantes que hay que entender bien: sesgo y alucinación. El primero tiene que ver con la representatividad de los datos que se han suministrado a la IA como set de entrenamiento. A menudo el modelo simplemente reproduce aquello con lo que lo han entrenado. Como lo hemos alimentado con montones de casos en los que, por ejemplo, se resuelve el problema del barquero correctamente, entonces devuelve esa misma solución aunque ahora ya no tenga sentido. No es un error, es el funcionamiento esperado, solo que nos genera un problema cuando usamos la herramienta para hacer tareas para las que no está pensada.

Pero eso sí, cuando el set de datos de entrenamiento contiene un sesgo (por ejemplo de género, de raza…) el modelo lo va a reproducir salvo que le pongamos alguna limitación ad hoc. Hay montón de ejemplos documentados de sesgos en las respuestas de ChatGPT, hasta el punto de que sus creadores lo han reconocido (Piers, 2024).

El segundo concepto importante tiene un nombre gracioso, “alucinación” (Ji et al., 2023), que viene a significar que, en su proceso de generar textos superficialmente creíbles, el modelo puede… inventarse cosas. Puede producir falsedades, puede inventarse las referencias. Y ojo, todo esto mientras usa un lenguaje convincente y persuasivo con mucha seguridad (Dolan, 2024). Ha habido casos curiosos, como por ejemplo una IA que recomendó un banco de alimentos como si fuera una atracción turística, un abogado que preparó su caso con ChatGPT para descubrir que estaba lleno de jurisprudencia inventada y acabó pagando un multazo de 5000 dólares, una IA que recomendó tirarse de un puente a una persona con depresión (yo no me estoy inventando nada de esto), y otros muchos.

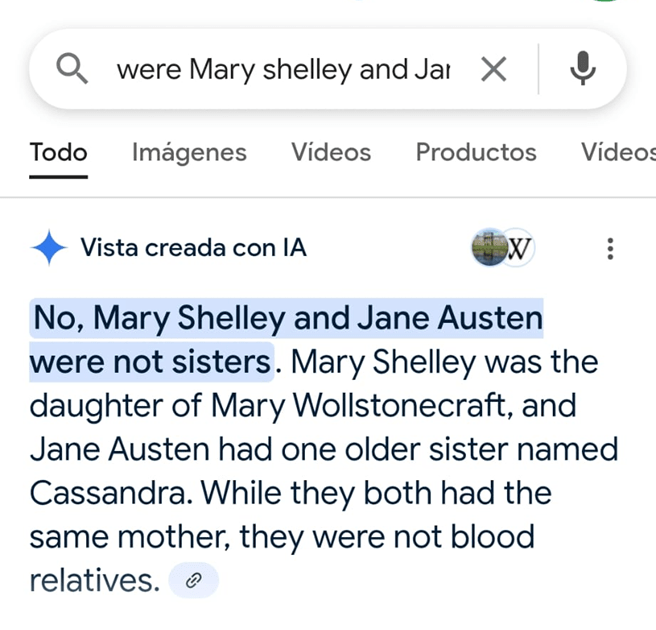

Un ejemplo que encontré el otro día con las búsquedas de Google, ahora que le han metido la IA con calzador hasta en la sopa: ¿Eran hermanas Mary Shelley y Jane Austen?

Ahora bien, para ser justos, muchos de estos ejemplos corresponden a versiones antiguas de los modelos. Posteriormente (a partir de la versión que usa ChatGPT 4) se han incorporado a los LLM lo que llaman “modelos de razonamiento”, que se basan en aprendizaje por reforzamiento. Gracias a esta innovación, el modelo puede “reconstruir” un proceso de razonamiento. Es decir, puede elaborarte los pasos por los que ha llegado a una conclusión, y esto permite resolver algunos problemas que hace solo unos meses eran imposibles. ¿Significa esto que ChatGPT ya puede “pensar”? Me temo que no.

En primer lugar, los propios desarrolladores (Anthropic) reconocen que no siempre lo que “dice” el modelo se corresponde con lo que “piensa” (Chen et al., 2025). Además no hay evidencia de que este razonamiento sea tal, y se han identificado las limitaciones de la actual arquitectura y estrategia para solucionar problemas de complejidad alta, por eso se habla de la “ilusión de razonamiento” (Shojaee et al., 2025).

Además, está el dato (también reconocido por los desarrolladores) de que los errores no han disminuido al incorporar sistemas de razonamiento, sino justo al contrario: las alucinaciones han aumentado, especialmente con determinadas tareas en los últimos meses.

Como observación informal: ¿nunca habéis pensado “qué inteligente es ChatGPT para responder a cosas que desconozco, pero qué ceporra cuando le pregunto cosas que yo ya sé?” Es que siempre da el pego, está diseñada para eso. La validez del contenido es secundaria para estos modelos, es de hecho un subproducto. La conclusión de toda esta argumentación es que utilizar una herramienta de IA generativa como ChatGPT sin la adecuada supervisión humana se consideraría un uso irresponsable de la misma. ¿Estamos de acuerdo?

El problema es que cuando nos llevamos el uso de la herramienta al terreno educativo, el potencial usuario o usuaria está aprendiendo, y por lo tanto a menudo carece de la capacidad de verificar lo que está leyendo. Es decir, que sin la presencia vigilante de un/a docente, estamos dejando al alumnado a merced de una máquina de desinformación que además es ultra-persuasiva.

Problemas adicionales

Evidentemente, en este análisis superficial dirigido a argumentar mi postura me he dejado en el tintero un montón enorme de posibles problemas que ni he mencionado, pero que son importantes, de hecho muy importantes: cuestiones éticas (¿quién ha entrenado este sistema, con qué información?), de privacidad (¿de verdad estamos cediendo alegremente nuestros datos, los de nuestro alumnado, a cambio del privilegio de entrenar su herramienta?), e incluso consecuencias medioambientales (que parece una tontería pero no lo es). En fin, me he centrado en unos problemas pero no quiero desmerecer otros que también son relevantes.

Algunos posibles usos de la IA en el aula

Para terminar, voy a dar rápidamente mi opinión, dados los razonamientos que he expuesto arriba, acerca de algunos posibles usos de ChatGPT por parte del alumnado.

- Preguntar dudas de la materia: Es un uso que veo bastante extendido. Te explican una cosa en clase, no acabas de entenderla, y le preguntas al chatbot para que te la explique. ¿Es este un uso responsable? En principio no habría problema con los dos primeros criterios que he propuesto. Ahora bien, tenemos problemas con el tercero. Si ChatGPT se vuelve majareta, alucina, y contesta alguna tontería, ¿será el alumnado capaz de detectar el error? ¿Y si te retransmite un sesgo aunque sea de manera accidental? ¿No sería mejor preguntar al profesor o profesora, que para eso están y se supone que son expertos en la materia?

- Realizar tareas mecánicas y sencillas, pero a menudo tediosas o pesadas: Por ejemplo, podrías generar datos aleatorios que cumplan unas condiciones para luego analizarlos en clase de estadística. Podrías reestructurar código de programación, o automatizar envío de e-mails, o transformar archivos de un formato a otro, reestructurarlos… Si no son habilidades que ahora mismo estén siendo evaluadas o que tengas que ejercitar en este preciso momento (requisitos 1 y 2), no veo problema, dado que la herramienta te facilita la vida y no afecta a tu aprendizaje. Además las tareas sencillas son resolubles con los nuevos sistemas que incorporan modelos de razonamiento, como hemos explicado.

- Buscar información: Anteriormente los LLM como ChatGPT estaban offline, lo que quiere decir que no podían acceder a internet para consultar información, y si preguntabas por un tema actual te lo indicaban amablemente en la respuesta (“lo siento, pero no me han entrenado para responder a esta cuestión”). Actualmente, el bot puede conectarse y buscar información en tiempo real, lo que lo hace mucho más potente. Ahora bien: NO es un buscador de información, no se ha diseñado para eso. Puede bucear en internet, pero no sabe distinguir una fuente fiable de cualquier paginucha de mandangas. Y además no te va a devolver el enlace directamente, sino que te lo va a transformar en una respuesta expresada con convicción. Confiar en esa respuesta sin verificarla es equivalente a clicar en el primer enlace que te da Google y darle credibilidad. Hoy por hoy, es una mala idea: un estudio encontró que los LLM tienden a citar fuentes incorrectas ¡o inexistentes! entre un 37% (Perplexity.ai) y un 94% (Grok) del tiempo (Jaźwińska & Chandrasekar, 2025).

- Pedir que te resuelva los deberes: Aunque no lo parezca a primera vista, aquí para determinar si el uso es responsable o no tenemos que hacernos algunas preguntas. En primer lugar, ¿es una actividad que está siendo evaluada en este momento? Quizá estemos ante una evolución mal diseñada si se puede resolver de esta manera, pero quizá estés haciendo un uso irresponsable de la herramienta, equivalente a pedir a tu papá que te haga un trabajo de clase. Por otro lado, imaginemos que utilizas la respuesta para intentar entender cómo ha llegado a la conclusión (que te describa los pasos, los razonamientos). Eso sí sería una experiencia de aprendizaje válida e incluso enriquecedira (siempre que puedas verificar que los pasos son correctos, ojo, para cumplir el requisito 3) y por eso en principio lo veo bien. Aunque quizá lo razonable sería pedirle a tu profesor o profesora que la próxima vez te proporcione un problema resuelto con todos los pasos a modo de ejemplo, para que no tengas que confiar en una máquina. ¿No sería mucho mejor?

- Procesar y combinar textos, como los apuntes, o extraer los puntos clave para luego estudiar. En principio, me parece un buen uso siempre y cuando puedas verificar que el resultado es correcto (requisito 3).

- Pulir el idioma, o la expresión, o la ortografía de un trabajo. En el nivel en el que yo ejerzo mi docencia (universitario), a menudo se suele entender que estas cuestiones corresponden a habilidades que ya están adquiridas o bien son hasta cierto punto irrelevantes para lo que se quiere evaluar. Generalmente yo quiero saber si has entendido conceptos de psicología, no si sabes escribir de manera más o menos legible. Por lo tanto, no veo el problema en que ChatGPT “edite” tu texto para hacerlo más legible sin cambiar el contenido. Siempre que el contenido lo hayas elaborado tú.

- Traducir documentos de otro idioma: Lo mismo. Salvo que el objetivo de la actividad sea adquirir soltura con ese idioma, en cuyo caso sería como el notas de arriba que se llevaba una carretilla elevadora al gimnasio e incumplirías el requisito 2, esta habilidad no necesitas ejercitarla en este momento, porque tú lo que quieres es documentarte. Por tanto, adelante.

- Resumir un texto: Esto es más delicado. Por un lado, se aplica lo que al caso anterior. Si el sentido de la actividad que te han propuesto no es adquirir o ejercitar la habilidad de comprender el texto (requisito 2), sino que simplemente lo necesitas para documentarte, adelante. Por otro lado, cumplir con el requisito 3 nos lleva a la dificultad de verificar un resumen de un texto que no te has leído. Y de hecho ChatGPT comete errores garrafales al resumir textos, como muestran las investigaciones («When ChatGPT Summarises, It Actually Does Nothing of the Kind.», 2024).

Referencias

- Bin-Nashwan, S. A., Sadallah, M., & Bouteraa, M. (2023). Use of ChatGPT in academia: Academic integrity hangs in the balance. Technology in Society, 75, 102370. https://doi.org/10.1016/j.techsoc.2023.102370

- Chen, Y., Benton, J., Radhakrishnan, A., Uesato, J., Denison, C., Schulman, J., Somani, A., Hase, P., Wagner, M., Roger, F., Mikulik, V., Bowman, S., Leike, J., Kaplan, J., & Perez, E. (2025). Reasoning Models Don’t Always Say What They Think. https://assets.anthropic.com/m/71876fabef0f0ed4/original/reasoning_models_paper.pdf

- Costello, T. H., Pennycook, G., & Rand, D. (2025). Just the facts: How dialogues with AI reduce conspiracy beliefs. OSF. https://doi.org/10.31234/osf.io/h7n8u_v1

- Costello, T. H., Pennycook, G., & Rand, D. G. (2024). Durably reducing conspiracy beliefs through dialogues with AI. Science (New York, N.Y.), 385(6714), eadq1814. https://doi.org/10.1126/science.adq1814

- Dolan, E. W. (2024, junio 9). Scholars: AI isn’t «hallucinating» — it’s bullshitting. PsyPost – Psychology News. https://www.psypost.org/scholars-ai-isnt-hallucinating-its-bullshitting/

- Illeris, K. (2004). Transformative Learning in the Perspective of a Comprehensive Learning Theory. Journal of Transformative Education, 2, 79-89. https://doi.org/10.1177/1541344603262315

- Jaźwińska, K., & Chandrasekar, A. (2025). AI Search Has A Citation Problem. Columbia Journalism Review. https://www.cjr.org/tow_center/we-compared-eight-ai-search-engines-theyre-all-bad-at-citing-news.php

- Ji, Z., Lee, N., Frieske, R., Yu, T., Su, D., Xu, Y., Ishii, E., Bang, Y., Chen, D., Dai, W., Chan, H. S., Madotto, A., & Fung, P. (2023). Survey of Hallucination in Natural Language Generation. ACM Computing Surveys, 55(12), 1-38. https://doi.org/10.1145/3571730

- McClelland, D. C. (1973). Testing for competence rather than for «intelligence.» American Psychologist, 28(1), 1-14. https://doi.org/10.1037/h0034092

- Merlan, A. (2025). Meet the Educational Entrepreneurs Who Want to Teach a New Generation of Elon Musks. Mother Jones. https://www.motherjones.com/politics/2025/03/elon-musk-schools/

- Piers. (2024). Even ChatGPT Says ChatGPT Is Racially Biased. Scientific American. https://www.scientificamerican.com/article/even-chatgpt-says-chatgpt-is-racially-biased/

- Shojaee, P., Mirzadeh, I., & Alizadeh, K. (2025). The Illusion of Thinking: Understanding the Strengths and Limitations of Reasoning Models via the Lens of Problem Complexity. https://ppc.land/content/files/2025/06/the-illusion-of-thinking.pdf

- Vicente, L., & Matute, H. (2023). Humans inherit artificial intelligence biases. Scientific Reports, 13(1), Article 1. https://doi.org/10.1038/s41598-023-42384-8

- Walsh, J. D. (2025). Rampant AI Cheating Is Ruining Education Alarmingly Fast. Intelligencer. https://nymag.com/intelligencer/article/openai-chatgpt-ai-cheating-education-college-students-school.html

- When ChatGPT summarises, it actually does nothing of the kind. (2024). R&A IT Strategy & Architecture. https://ea.rna.nl/2024/05/27/when-chatgpt-summarises-it-actually-does-nothing-of-the-kind/